界面新闻记者 |

界面新闻编辑 | 文姝琪

5月20日至21日,搜索巨头谷歌在加州山景城海岸线圆形剧场举办一年一度的Google I/O大会(开发者大会)。

自从2024年I/O大会上,谷歌CEO桑达尔·皮查伊(Sundar Pichai)宣布Google进入“Gemini时代”后,AI就成了大会重头戏。

今年也不例外,首日的核心就是GeminiAI相关的新产品升级。桑达尔·皮查伊、谷歌Deepmind CEO、2024诺贝尔化学奖得主戴密斯·哈萨比斯(Demis Hassabis)等一众高管登台亮相,介绍展示了新的推理AI模型Gemini2.5 Pro、引入Gemi2.5后的Google AI搜索、 Android XR以及Google眼镜等功能和服务的重大更新。

升级版推理模型:“更懂思考的”Gemini2.5 Pro

谷歌在会上发布的最重要的AI产品是其Gemi2.5的升级版模型——Gemini2.5 Pro。

Gemini2.5 Pro是Gemini系列最新的推理旗舰模型,对标OpenAI o3。相对于Gemini2.5,Gemini 2.5 Pro在其基础上进一步增强了复杂任务处理能力,尤其在代码生成、逻辑推理和多模态理解方面表现有了极大提升。

据Deepmind CEO哈萨比斯介绍,Gemini 2.5 Pro具备深度思考能力,能够在回答前“思考”多个假设,进行复杂的逻辑推理和信息分析,并具备“思维链”功能,能够在回答时展示完整的思考步骤和多种选择方案。

在评价模型能力的LMArena排行榜上,Gemini 2.5 Pro在所有类别(对话能力、代码生成、图文生成以及综合评分项目)中都排名第一。

谷歌在现场重点演示了其AI Coding的能力,按照官方定位,相对于Gemini 2.5,Gemini2.5 Pro是一款“更擅长编程”的模型。

据现场工作人员介绍,Gemini 2.5Pro特别擅长创建视觉效果丰富的网页应用,包括UI设计、响应式布局和复杂交互动画的生成。工作人员现场演示了一项前端网页编程任务,将几十张2D图片改成3D排列,仅通过几个简单的提示词,模型不到一分钟时间就自动完成了编码实现。

在衡量AI编程能力的排行榜WebDev Arena上,Gemini 2.5Pro居于首位,比其上一个版本提升了142分,超过了包括Claude 3.7 Sonnet和GPT-4.1 Turbo等竞争对手。

除了编程能力外,多模态能力也是Gemini一直重点提升的核心。

谷歌公布了Gemini Live API的预览版。Live API支持文本转语音、语音转语音,做到以视听输入和输出音频对话,早期功能有情感对话(Affective Dialogue)、主动音频功能(Proactive Audio)。情感对话能够检测用户声音中的情感并作出适当回应。主动音频功能下模型将忽略背景对话并知道何时回应。

Live API 支持超过24种语言,并可以在它们之间无缝切换,目前已在 Gemini API 中可用。

在集中体现多模态能力的“世界模型”上,伴随Gemini 2.5Pro的升级,谷歌旗下的视频生成模型、音频生成模型、图像生成模型也升级到了新版本.

新的视频生成模型Veo3首次实现了视频与音频的原生同步生成。它不仅能生成高质量的视频画面,还能同步生成包括环境音效、角色对话和口型同步的音频内容。

音频生成模型Lyria 2能够支持生成高保真度、高质量的音乐,适用于品牌配乐、影视音乐和数字内容制作。

还有新的图像生成模型Imagen 4,生成的图像更加丰富,色彩更加细腻,细节更加逼真。

基于Gemini 2.5 Pro在深度思考、复杂任务上的能力,谷歌还在大会上宣布将计划通用人工智能助手Project Astra 、智能体系统应用(AI Agent)Project Mariner。Project Astra目前已经具备视频理解、屏幕共享和记忆等功能;Project Mariner 现在包含一个Agent智能体系统,可以同时完成多达十项不同的任务,如查找信息、订票、购物,相应的功能已经被整合进入Gemeni API中。

“Gemini所有应用目前月活跃用户已超过4亿。尤其是2.5系列模型的使用增长强劲和用户参与度很高。”谷歌CEO皮查伊在演讲中提到,世界正在加速拥抱AI——去年同期,Google 旗下Gemini所有模型API及AI产品每月处理9.7万亿个Token。而现在,这一数字已超过480万亿,前后增长了50多倍。

首次引入Gemeni 2.5 的谷歌搜索

在"老本行"搜索方面,这次I/O大会宣布将Gemini 2.5正式引入Google搜索引擎,面向美国用户全面开放。

引入AI模型的谷歌搜索将提供“AI mode”"AI Search”功能。皮查伊称,“AI搜索是对传统搜索引擎的颠覆”。

在AI Mode下,用户可以通过语音、文字、图片等多模态方式输入搜索问题,搜索引擎会自动分解查询意图,生成对应的答案,可以用在制定旅游行程、购物建议、编程指南等生活场景中。

此外,AI Mode将支持一系列全新的功能,比如:深度搜索(Deep Search)、实时互动搜索(Search Live)。

深度搜索可以支持AI模型自动发起上百次搜索,跨领域整合信息并生成引用详尽的专家级报告,节省大量人工研究时间。

实时互动搜索功能则基于Gemini模型和Live API技术,支持实时视频交互。用户在AI Mode界面下轻触“Live”图标后,可以直接通过手机摄像头对着现实场景进行“现场直播”提问:AI能够实时“看懂”摄像头画面内容,结合视觉信息进行理解和分析。实时以语音形式给出回答,并提供相关资源链接。

AI Mode已于2025年5月20日上线,作为搜索引擎的新标签页形式,面向美国用户开放。

新AI硬件:“Android XR”与AR眼镜

谷歌最后环节还展示了一系列新的AI硬件,头显XR与眼镜,这些新型硬件都是以其“Android XR”平台为基础开发构建。

Android XR是谷歌与高通、三星合作,专为扩展现实(XR)设备的开发平台。谷歌工程主管Shahram Izadi介绍称,除手机外,未来几个月里谷歌将会把Gemini AI功能拓展至智能手表、汽车控制台、电视及眼镜上。

谷歌宣布将与中国AR眼镜企业XREAL合作,发布新一代AR眼镜——Project Aura。作为谷歌首款专为Android XR平台打造的旗舰级AR眼镜,Project Aura基于OST(Optical See through,光学透视)技术路线,谷歌将在操作系统与XR生态提供平台支持,由XREAL提供轻量化AR眼镜硬件,并将搭载高通骁龙XR芯片。

谷歌团队人员现场演示了这款眼镜产品的新功能。眼镜内置谷歌最新的Gemini人工智能助手,支持通过对话回复短信、搜索眼前图片信息、实时导航等功能。

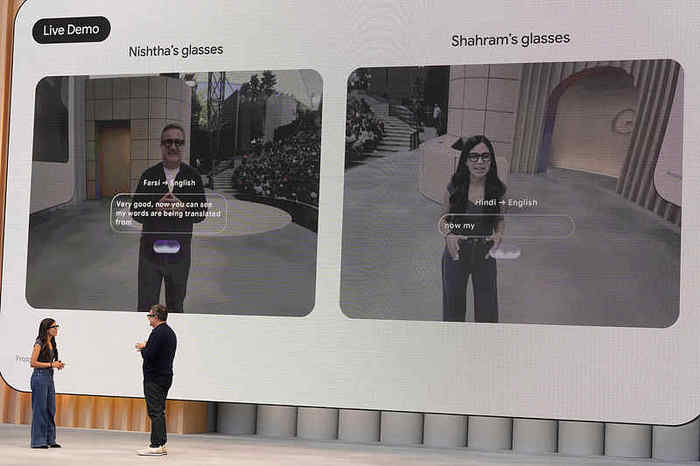

同时这款眼镜支持多语言即时翻译。两位工作人员在台上戴上眼镜面对面对话,演示了将波斯语和印地语对话翻译成英语的功能。

该眼镜预计今年下半年上市,谷歌还将与三星合作推出另一款头戴式MR设备“Moohan”。